<p>ReLU(Rectified Linear Unit)和SiLU(Sigmoid Linear Unit)都是常用的激活函数,它们的主要区别在于非线性形状不同。<br /> ReLU(Rectified Linear Unit)</p> 讯享网

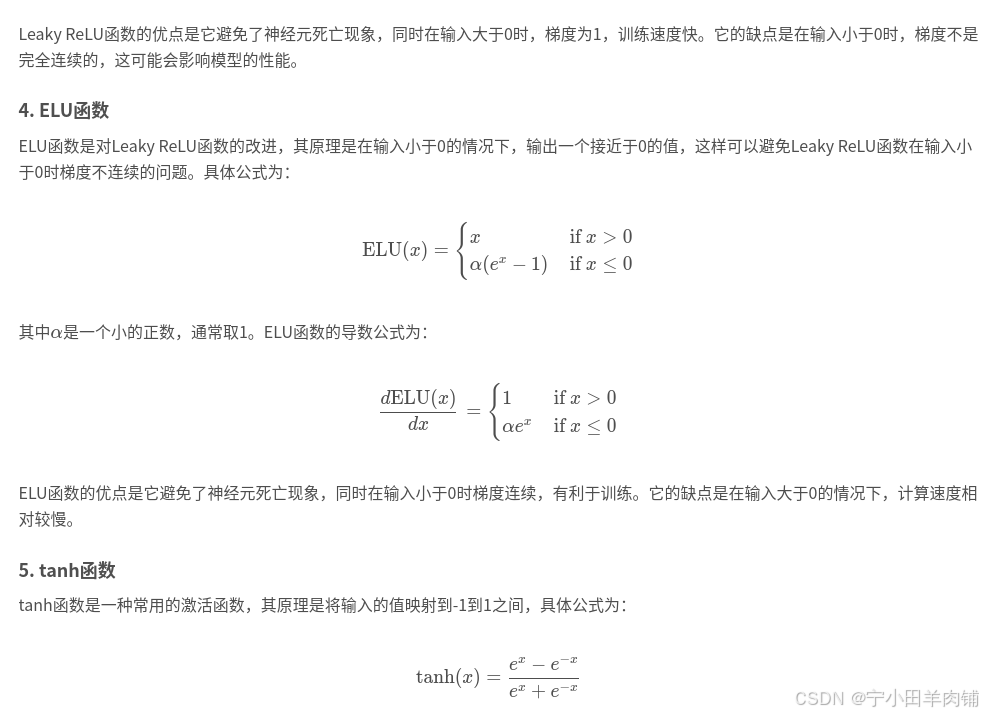

Leaky ReLU

概念:

Leaky ReLU是ReLU的一种变体,改变之处在于 负数的输出不再是0了,而是一个很小的数值,比如0.1或0.01。

优点:

Leaky ReLU的优点在于可以避免出现“神经元死亡”的情况,即在训练过程中某些神经元的输出始终为0,从而导致无法更新其权重,而Leaky ReLU可以在一定程度上解决这个问题。

FReLU(Flatten ReLU)

优点:

减少参数量:FReLU不需要额外的参数,因此可以减少模型的参数量。

具有更好的表示能力:由于FReLU可以将输入展平成一维向量,因此可以在不增加参数量的情况下提高模型的表示能力。

提高模型的鲁棒性:由于FReLU对输入进行了展平操作,因此可以提高模型对输入的鲁棒性,从而减少过拟合的风险。

SiLU(Sigmoid Linear Unit)

相对于ReLU函数,SiLU函数在接近零时具有更平滑的曲线,并且由于其使用了sigmoid函数,可以使网络的输出范围在0和1之间。这使得SiLU在一些应用中比ReLU表现更好,例如在语音识别中使用SiLU比ReLU可以取得更好的效果。

🤬————注意———-🤬:

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容,请联系我们,一经查实,本站将立刻删除。

如需转载请保留出处:https://51itzy.com/kjqy/175558.html