文 / Google Research 团队 Natasha Jaques 和加州大学伯克利分校 Michael Dennis

任何机器学习方法的有效性都主要取决于其训练数据。对于是强化学习 (RL),我们可以通过智能体 (Agent) 与现实世界互动收集的有限数据,也可以根据需要依赖于模拟训练环境收集尽量多的数据。后一种模拟训练方法越来越受欢迎,但也存在一个问题,即强化学习智能体可以学习模拟器中内置的内容,但往往在与之模拟的任务稍有不同内容的泛化时表现不佳。显然,想构建一个涵盖现实世界所有复杂性的模拟器是非常具有挑战性的。

- 现实世界互动

https://ai.googleblog.com/2018/06/scalable-deep-reinforcement-learning.html

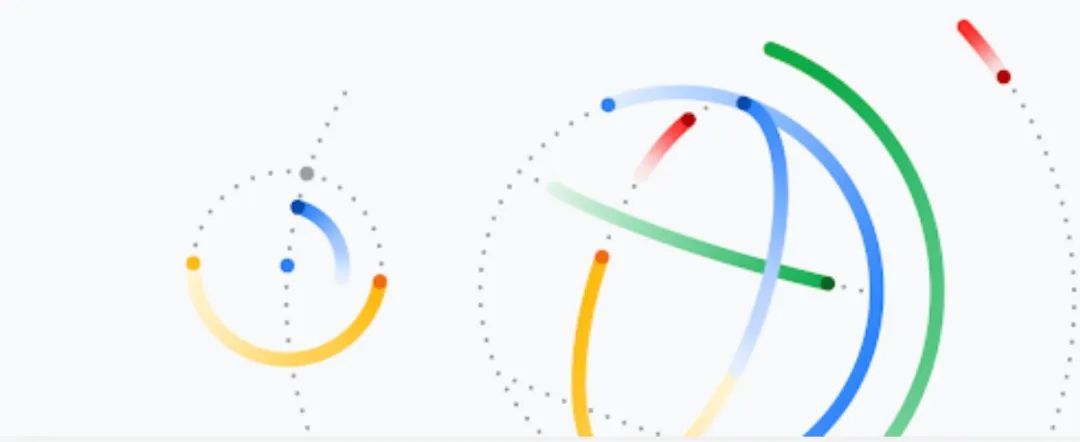

一种解决此问题的方法是通过随机化模拟器的所有参数来自动创建更多样化的训练环境,这一方法称为域随机化 (Domain Randomization)。但是,即使在非常简单的环境中,域随机化也有可能失效。例如,在下方动画中,蓝色智能体正在尝试导航到绿色目标。左侧面板显示的是使用域随机化创建的环境,其中障碍物和目标的位置均已随机化。在很多此类域随机化环境中训练智能体,然后将其转移到简单的“四个房间”环境中,如中间面板所示。请注意,此时智能体找不到目标。这是因为它还没有学会围绕墙壁行走。即使域训练阶段 可能 已经随机 化生成“四个房间”示例中的墙壁配置,智能体也不太可能学会。因此,智能体没有在类似于“四个房间”结构的墙壁上花费足够的时间来训练,并且无法找到目标。

域随机化(左)无法有效地让智能体做好准备,使其转移到以前未接触过的环境,例如“四个房间”场景(中)。为解决这个问题,我们使用了极小化极大对抗来构建以前未接触过的环境(右),但可能导致产生一些无法解析的情况

我们不仅可以随机化环境参数,还可以学习如何设置环境参数来训练第二个强化智能体。经训练该极小化极大对抗者可通过发现和利用第一个强化智能体的策略弱点,例如构建智能体以前从未遇到过的墙壁配置,从而最大程度地降低其表现水平。但这同样也存在一个问题。右侧面板中展示了一个由极小化极大对抗者所构建的环境,在该环境中,智能体实际上不可能找到目标。虽然极小化极大对抗者已成功完成最大限度地降低了原始智能体的表现水平的任务,但它没有为智能体提供任何学习的机会。同样,使用纯粹的对抗目标也不太适合生成训练环境。

- 极小化极大对抗者

https://pubsonline.informs.org/doi/pdf/10.1287/opre.1050.02

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容,请联系我们,一经查实,本站将立刻删除。

如需转载请保留出处:https://51itzy.com/kjqy/24882.html