在深度学习的开发环境中,尤其是使用 PyTorch 时,您可能会遇到内存管理方面的问题。 是一个环境变量,允许您配置 HIP(Heterogeneous-compute Interface for Portability)内存的分配设置。本文将为您提供如何实现这一配置的详细流程和每一步所需的代码示例,帮助您更好地理解如何配置该参数。

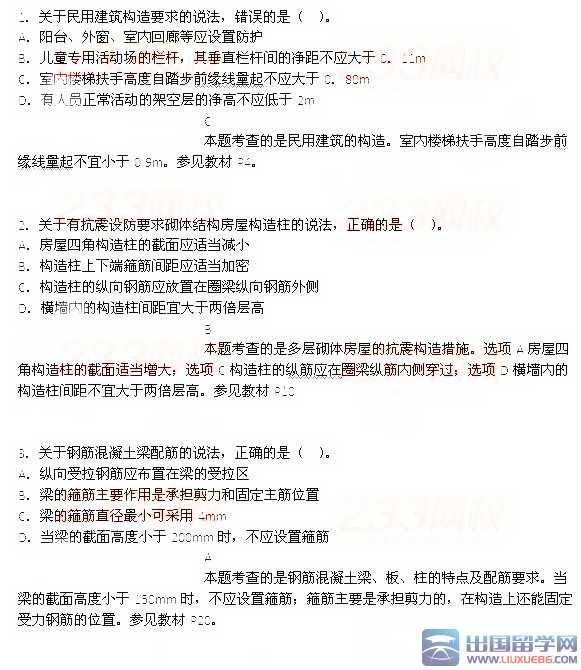

以下是实现 的步骤:

1. 安装必要的库和工具

首先,确保您已经安装了 PyTorch 和相关的 HIP 工具。如果您尚未安装,请运行以下命令:

讯享网

解释: 这段代码通过 pip 安装了 PyTorch 及其相关库,确保你在运行代码时可以顺利调用这些库。

2. 设置环境变量 PYTORCH_HIP_ALLOC_CONF

接下来,您需要设置环境变量 。我们可以在命令行中设置它,或者在 Python 脚本中进行配置。以下是两种方法。

方法 A: 在命令行中设置

在您的终端输入以下命令以设置环境变量:

讯享网

解释: 这行代码将环境变量 设置为 ,即换句话说,最大分块内存为 2048MB。

方法 B: 在 Python 中设置

如果您希望在 Python 脚本中设置环境变量,可以使用以下代码:

解释: 这段代码在 Python 中配置了同样的环境变量,确保在脚本运行时能够生效。

3. 编写和测试代码

接下来,您可以开始编写使用 PyTorch 的代码。例如,你可以创建一个简单的张量并查看使用的内存情况:

讯享网

解释: 这段代码在 GPU 上创建了一个 10000x10000 大小的随机张量。在这之前,请确保您已安装 CUDA 的支持。

4. 观察和调试

最后,观察输出和内存分配情况。如果发现内存溢出或慢的性能,您可以考虑调整 的值,使其适应您的需求。例如,您可能会将其调整为 。

以下是您在配置和调整 时可能经历的旅程(使用 mermaid 语法):

以下是整个过程的时间线(使用 mermaid 语法):

讯享网

通过以上步骤,您现在应该能够成功配置和使用 ,提升 PyTorch 在您的应用中的性能和稳定性。记住,优化内存使用是深度学习中的一个重要环节,调整这些设置将有助于更好地操作大型数据集和复杂模型。希望这篇教程对您有帮助!如果您有任何问题,请随时询问。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容,请联系我们,一经查实,本站将立刻删除。

如需转载请保留出处:https://51itzy.com/kjqy/167031.html