<p>CNN,全称为Convolutional Neural Networks,即卷积神经网络,是一种特殊类型的多层神经网络,特别擅长处理图像相关的问题。CNN由Yann LeCun于1998年首次提出,并已成功应用于各种图像识别任务中。</p> 讯享网

CNN的基本结构可以分为三个部分:卷积层、池化层和激活函数。其中,卷积层是CNN的核心部分,负责提取输入数据的特征。它通过卷积核(也称为滤波器或特征映射)在输入数据上滑动并进行卷积运算,以捕捉图像中的局部特征。每个卷积核都可以学习并提取一种特定的特征,例如边缘、纹理或颜色等。

池化层则负责降低数据的维度,减少计算量和过拟合的风险。它通过聚合相邻的像素值来减少图像的大小,同时保留重要的特征信息。常见的池化操作包括最大池化和平均池化等。

激活函数则用于引入非线性因素,增强模型的表达能力。常见的激活函数包括ReLU、Sigmoid和Tanh等。

CNN的成功之处在于其采用的局部连接和权值共享的方式。局部连接意味着每个神经元只与输入数据的一个局部区域相连,这大大减少了权值的数量,使得网络更易于优化。权值共享则意味着在同一个卷积层中,多个神经元可以使用相同的卷积核,这进一步降低了模型的复杂度,并减少了过拟合的风险。

CNN在图像处理领域具有广泛的应用,包括图像分类、目标检测、人脸识别等。它能够自行抽取图像的特征,包括颜色、纹理、形状及图像的拓扑结构,对于识别位移、缩放及其他形式扭曲不变性的应用具有良好的鲁棒性和运算效率。

CNN(卷积神经网络)的公式推导主要涉及到卷积层和池化层的计算过程以及参数的更新。下面简要介绍一下卷积层的计算过程和参数更新的基本思路。

- 卷积层的计算过程:

对于输入图像或特征图,将其转化为矩阵形式,矩阵的元素为对应的像素值。然后,定义一个卷积核(也称为滤波器),它是一个较小的矩阵。卷积核在输入矩阵上滑动,并进行卷积运算,即将卷积核中的元素与输入矩阵对应位置的元素相乘并求和。这个求和的结果加上一个偏置参数后,通过激活函数(如ReLU)得到输出特征图的一个元素。卷积核在输入矩阵上滑动的过程中,会生成整个输出特征图。

具体的卷积计算公式可以根据不同的卷积方式和步长等因素而有所不同。但基本的思想是利用卷积核捕捉输入数据的局部特征,并通过激活函数引入非线性因素。

- 参数更新:

CNN的参数主要包括卷积核的权重和偏置参数。在训练过程中,需要通过反向传播算法和梯度下降等方法来更新这些参数,以最小化损失函数并提高模型的性能。

反向传播算法的基本思路是根据损失函数对输出层的梯度,逐层向前计算每个参数的梯度,并根据梯度更新参数。对于卷积层,需要计算损失函数对卷积核权重和偏置参数的梯度。这可以通过链式法则和卷积运算的性质来实现。

需要注意的是,由于卷积层具有权值共享的特点,即多个神经元使用相同的卷积核,因此在计算梯度时需要考虑权重的共享性。这意味着对于同一个卷积核,需要将其在不同位置的梯度进行累加,以得到最终的权重更新。

Python代码如下:

讯享网# 导入必要的库: import numpy as np import matplotlib.pyplot as plt import tensorflow as tf from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense, Conv1D, Flatten from sklearn.model_selection import train_test_split from sklearn.metrics import mean_squared_error生成随机数据:

设置随机数种子以确保结果可复现

np.random.seed(0)生成随机输入数据 X 和目标数据 y

X = np.random.rand(1000, 100, 1) # 1000个样本,每个样本100个时间步长,1个特征 y = np.random.rand(1000) # 1000个对应的目标值划分数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)构建CNN模型:

model = Sequential() model.add(Conv1D(filters=64, kernel_size=3, activation=‘relu’, input_shape=(X_train.shape[1], 1))) model.add(Conv1D(filters=64, kernel_size=3, activation=‘relu’)) model.add(Flatten()) model.add(Dense(50, activation=‘relu’)) model.add(Dense(1)) # 输出层,一个神经元用于回归任务编译模型

model.compile(optimizer=‘adam’, loss=‘mse’)训练模型:

history = model.fit(X_train, y_train, epochs=50, batch_size=32, validation_split=0.1)进行预测并评估模型

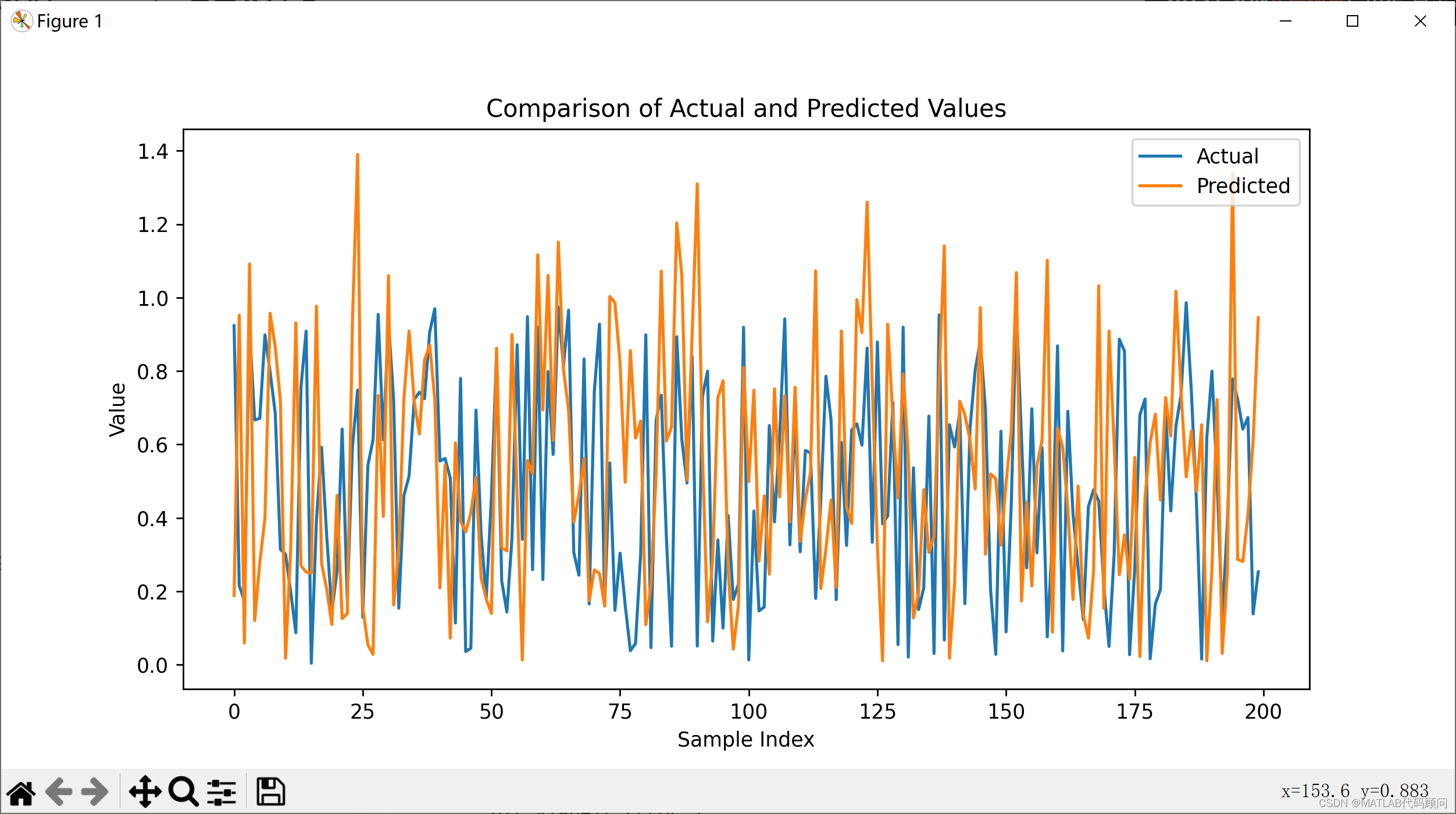

y_pred = model.predict(X_test) mse = mean_squared_error(y_test, y_pred) print(f‘Test MSE: {mse}’)绘制实际值和预测值的比较图

plt.figure(figsize=(10, 5)) plt.plot(y_test, label=‘Actual’) plt.plot(y_pred.flatten(), label=‘Predicted’) plt.title(‘Comparison of Actual and Predicted Values’) plt.xlabel(‘Sample Index’) plt.ylabel(‘Value’) plt.legend() plt.show()errors = y_test - y_pred.flatten() plt.figure(figsize=(10, 5)) plt.plot(errors, label=‘Errors’) plt.title(‘Prediction Errors’) plt.xlabel(‘Sample Index’) plt.ylabel(‘Error’) plt.legend() plt.show()

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容,请联系我们,一经查实,本站将立刻删除。

如需转载请保留出处:https://51itzy.com/kjqy/149344.html